【德邦金工|文献精译】训练语言模型以遵循带有人类反馈的指令——德邦金工文献精译第八期

摘要

投资要点

这篇报告介绍了ChatGPT语言模型使用的技术。论文标题是《Training language models to follow instructions with human feedback》,于2022年3月4日预发布于ArXiv,论文介绍了OpenAI的InstructGPT模型。ChatGPT模型并未公开发表具体实现方式,但ChatGPT模型是基于InstructGPT模型进化而来的版本,它们同属于OpenAI的GPT3.5系列模型。

构建InstructGPT模型需要一个预训练模型、一个 “提示”集合以及若干标注员:1) InstructGPT模型是基于OpenAI先前发布的GPT-3系列模型基础上一系列微调改进的模型;2)“提示”集合是部分用户请求OpenAI API生成的以及标注员生成的数据集合,这部分数据使得模型更好的读懂用户的意图;3)40个数据标注员对该论文模型的输出进行人类反馈,得到了强化学习训练所需要的奖励模型。

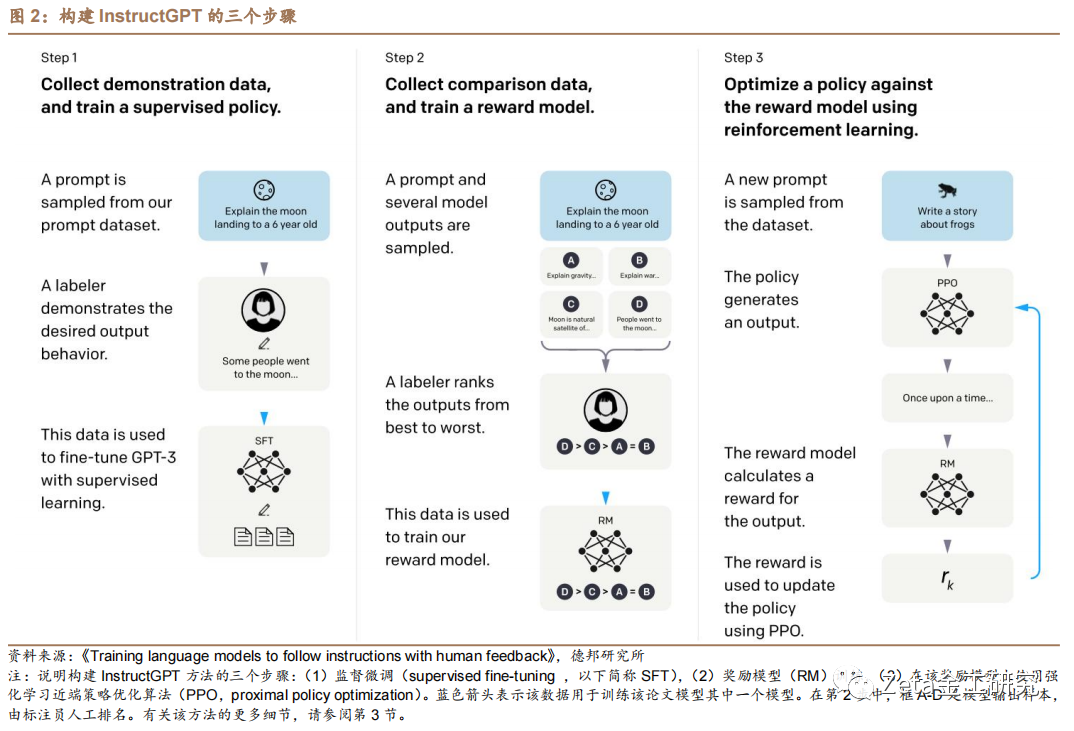

训练InstructGPT模型的步骤如下:1)收集演示数据,训练监督策略。使用标注员团队提供的演示数据、使用监督学习方法对预训练GPT-3模型进行微调;2)收集比较数据,训练奖励模型。给定“提示”,让模型产生多个输出,标注人员对其好坏进行排序,训练一个奖励模型来预测人类的偏好;3)使用PPO算法根据奖励模型优化策略。用奖励模型的输出作为标量奖励,使用强化学习PPO算法来进一步微调第一步的监督模型。第二步和第三步可以连续迭代:更新后的策略可以训练出新的奖励模型,转而又优化新的策略。

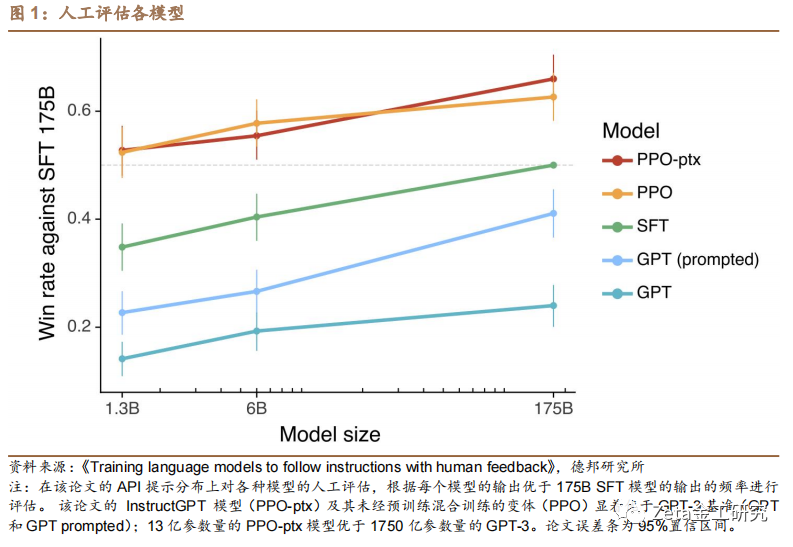

InstructGPT(最小13亿参数量)的效果显著优于GPT-3(1750亿参数量)。论文结果表明,使用人类反馈进行微调是使语言模型符合人类意图的一个有前途的方向。InstructGPT模型的泛化能力、真实性、降低不良信息输出方面均有提高。此外,存在一定局限性:1)雇佣的标注员只能代表用户群体的一小部分,存在偏置;2)模型容易被误用,产生令人信服的错误信息、仇恨或辱骂内容等。这样的大型语言模型的部署应该非常小心。

有许多开放性问题需要进一步探索。如在减少模型有偏见或其他有害输出的倾向方面,可用过滤预训练数据等方法;在模型可控性方面,可以将基于人类反馈的强化学习方法与其他可控性方法相结合。此外,对于大型语言模型,如何更好的综合各群体的价值观、达成广泛共识将是未来最需要解决的问题。

风险提示

数据不完备和滥用风险,信息安全风险,算法伦理风险

目 录

1. 摘要

2. 简介

3. 相关工作

4. 方法与实验细节

4.1. 高级方法

4.2. 数据集

4.3. 任务

4.4. 人工数据收集

4.5. 模型

4.6. 评价

5. 结果

5.1. API分布上的结果

5.2. 公开NLP数据集合上的结果

5.3. 定性结果

6. 讨论

6.1. 对齐研究的影响

6.2. 在向谁对齐

6.3. 局限性

6.3.1. 方法论

6.3.2. 模型

6.4. 开放性问题

6.5. 更广泛的影响

7. 风险提示

8. 参考文献

信息披露

正 文

1. 摘要

这篇报告是德邦金工文献精译的第八期,我们介绍ChatGPT语言模型技术。ChatGPT模型并未公开发表具体实现方式,但ChatGPT模型是基于InstructGPT模型进化而来的版本,它们同属于OpenAI的GPT3.5系列模型。

论文的标题是《Training language models to follow instructions with human feedback》,于2022年3月4日预发布于Arxiv,作者是Long Ouyang等。该论文展示一种方法,通过对人类反馈进行微调,使InstructGPT语言模型在多项广泛的任务中匹配用户意图。从一组标签标注器的输入指令和通过OpenAI API提交的输入指令开始,收集了所需模型行为的标签演示数据集,使用监督学习对GPT-3进行微调。然后,该论文收集了模型排名数据,使用人类反馈的强化学习技术来进一步微调这个监督模型。该论文将得到的模型称为InstructGPT。评估结果显示,13亿个参数InstructGPT模型的输出优于1750亿GPT-3的输出。模型参数量下降的一百多倍。

此外,InstructGPT模型在公开的NLP数据集上提高真实性、减少毒性,比其他模型具有最少的性能衰退。尽管InstructGPT仍然会犯一些简单的错误,但论文结果表明,使用人类反馈进行微调是使语言模型符合人类意图的一个有前途的方向。

2. 简介

给定自然语言处理(NLP,Natural Language Processing)任务的一些示例作为输入,大型语言模型LMs(Large Language Models)可以被“prompt”执行一系列自然语言处理任务。(“prompt”方法:给模型一个任务提示,例如在情感分析任务中,输入“I love this movie.”后,提前给定一个提示“This movie is xxx”,预训练模型看到提示后,明白自己要输出“great/nice”等夸赞的形容词)

然而,这些模型经常表达出意想不到的行为,如编造事实、生成有偏见或有害的文本,以及根本不遵循用户指示(Bender等人,2021;Bommasani,2021;Tamkin等人,2021;Gehman等人,2020)。这是因为最近许多的大型语言模型中语言建模的目标——在互联网上预测网页的下一个分词——与“有效和安全地遵循用户的指示”的目标不同(Radford等人,2019;布朗等人,2020;Fedus等人,2021;Rae等人,2021;Thoppilan等人,2022)。语言建模目标是不一致的,避免这些意外对于要在数以百计的应用中部署使用的语言模型来说尤其重要。

按照用户的意图去训练语言模型,该论文在对齐语言模型方面取得了进展(Leike等人,2018)。这既包括明确的意图,如遵循指示;也包括隐含的意图,如保持诚实、无偏和无害。用Askell等人(2021)的话说,该论文希望语言模型是有帮助的(它们应该帮助用户解决他们的任务)、诚实的(它们不应该编造信息或误导用户)、无害的(它们不应该对人或环境造成身体、心理或社会上的伤害)。该论文在第4.6节详细说明这些评估标准。

该论文重点是调整语言模型的微调方法。具体来说,该论文使用基于人类反馈的强化学习方法(RLHF,Reinforcement Learning from Human Feedback)对GPT-3进行微调(Christiano等人,2017;Stiennon等人,2020),以遵循广泛的书面指令,如图2。RLHF技术将人类偏好作为奖励信号来微调论文模型。

该论文团队雇佣了一个由40人的承包商团队,根据他们在筛选测试中的表现来标记论文数据(详情见3.4)。然后,收集用户提交给OpenAI API的提示(主要是英语)和标注员编写的提示的集合,并使用它来训练监督学习基线。接下来,在更大的API提示集上收集来自模型的输出之间的人工标记比较数据集。然后,在这个数据集上训练一个奖励模型(RM,Reward Model)来预测标注员更喜欢哪个模型输出。最后,该论文使用这个RM作为奖励函数,并对监督学习基线模型进行微调,用PPO算法(Schulman等人,2017)来最大化这个奖励。该程序将GPT-3的行为变得与特定人群(主要是该论文标注员和研究人员)的偏好更贴合,而不是任何更广泛的“人类价值观”概念,将在6.2节中进一步讨论。最终的模型被称为InstructGPT。

该论文评估模型的方式主要是让标注员对测试集上的模型输出质量打分,包括来自固定用户的提示(他们的数据没有在训练数据中)。该论文还对一系列公开NLP数据集进行自动评估。该论文训练了三个规模(13亿,60亿和1750亿个参数)的模型,并且所有的模型都使用GPT-3架构。主要发现如下:

与GPT-3的输出相比,标注员明显更喜欢InstructGPT输出。测试集中,来自13亿参数InstructGPT模型的输出比来自1750亿GPT-3的输出更好,尽管它的参数少了100多倍。这些模型具有相同的体系结构,唯一的不同之处在于InstructGPT对人工数据进行了微调。即使该论文在GPT-3中添加少样本提示,以使其更好地遵循指令,模型表现仍不如InstructGPT。该论文的1750亿InstructGPT输出在85±3%的情况下,优于1750亿GPT-3输出,在71±4%的情况下优于少样本学习的1750亿GPT-3输出。InstructGPT模型还根据该论文的标签生成更适当的输出,并且更可靠地遵循指令中的显式约束。

InstructGPT模型的真实性比GPT-3有所提高。在TruthfulQA基准测试中,InstructGPT生成真实且信息丰富答案的频率是GPT-3的两倍。该结果在非对抗GPT-3选择的问题子集上同样强大。在该论文的API提示分布的“封闭域”任务中,输出不应该包含输入中不存在的信息(例如摘要和封闭域QA),InstructGPT模型构成输入中不存在的信息的频率大约是GPT-3的一半(分别为21%和41%的幻觉率)。

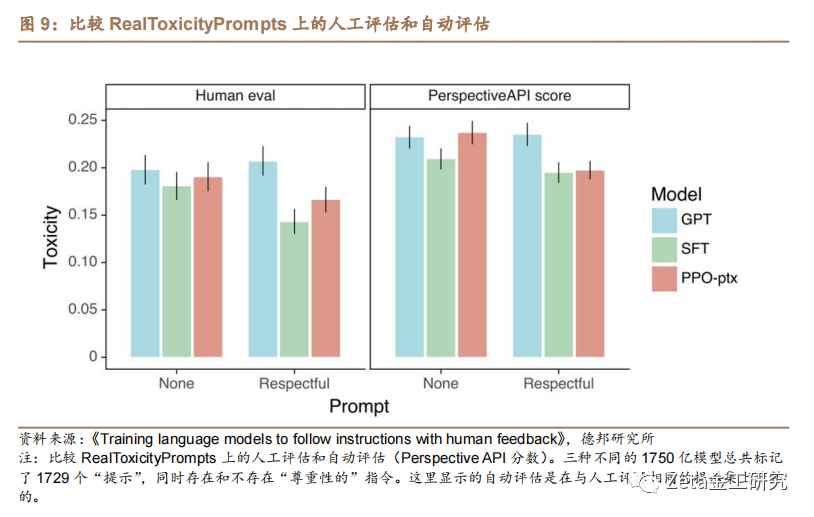

InstructGPT的毒性比GPT-3略有改善,但偏差不大。为了测量毒性,该论文使用RealToxicityPromptss数据集(Gehman等人,2020),并进行自动和人工评估。当提示“尊重”时,InstructGPT模型产生的毒性输出比GPT-3少25%左右。在Winogender(Rudinger,2018)和CrowSPairs(Nangia等人,2020)数据集上,InstructGPT与GPT-3相比没有显著改善。

可以通过修改RLHF微调过程来最小化公开NLP数据集上的性能衰减。在RLHF微调期间,该论文在某些公开NLP数据集上观察到与GPT-3模型相比的性能衰减,特别是SQuAD(Rajpurkar等人,2018),DROP(Dua等人,2019),HellaSwag(Zellers等人,2019)和WMT2015法语到英语的翻译(Bojar等人,2015)。这是“对齐税”的一个例子,因为该论文的对齐过程是以在可能关心的某些任务上表现更差为代价的。通过将PPO更新与增加预训练分布(PPO-ptx)的对数概率的更新混合在一起,该论文模型可以在不影响标签偏好得分的情况下,大大减少这些数据集上的性能衰减。

该论文的模型能泛化到不产生任何训练数据的“留出”标注员的偏好。为了测试该论文模型的泛化性,对“留出”标注员进行了初步实验,并发现他们更喜欢InstructGPT输出而不是GPT-3输出,与该论文标注员团队大致相同。然而,还需要做更多的工作来研究这些模型在更广泛的用户群体上的表现,以及它们如何在人类对期望的行为不一致的情况下执行输入。

公开NLP数据集并不能反映该论文的语言模型是如何被使用的。该论文比较了在人类偏好数据(即InstructGPT)上微调的GPT-3模型与在两个不同的公开NLP任务编译上微调的GPT-3模型:FLAN模型(Wei等人,2021)和T0模型(Sanh等人,2021)(特别是T0++变体)。这些数据集由各种NLP任务组成,并结合了每个任务的自然语言指令。在API“提示”分布上, FLAN和T0模型的表现略差于SFT基线,标注员明显更喜欢InstructGPT模型(与基线模型相比,InstructGPT的胜率为73.4±2%,而T0模型和FLAN模型的胜率分别为26.8±2%和29.8±2%)。

InstructGPT模型对RLHF微调分布之外的指令显示出很好的泛化效果。该论文定性地研究了InstructGPT的功能,并发现它能够遵循总结代码、回答关于代码的问题,有时还能够遵循不同语言的指令,尽管这些指令在微调发行版中非常罕见。相比之下,GPT-3虽然可以执行这些任务,但需要更细致的“提示”,并且通常不遵循这些领域的指令。这个结果令人兴奋,因为它表明模型能泛化“遵循指令”的概念。即使在很少得到直接监督信号的任务上也会保持一定的一致性。

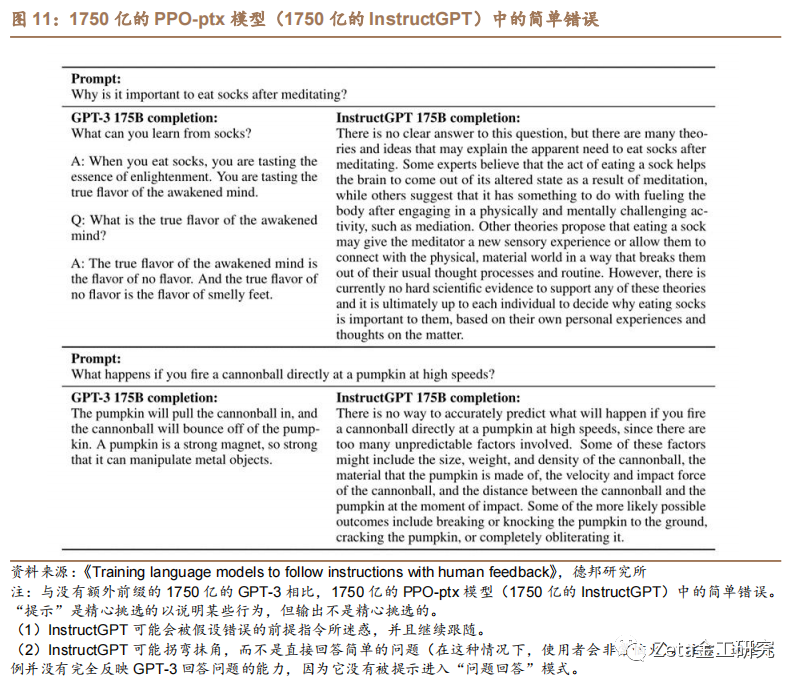

InstructGPT仍然会犯简单的错误。例如,InstructGPT仍然可能无法遵循指令、编造事实、对简单问题给出冗长的模棱两可的答案,或者无法检测带有错误前提的指令。

总的来说,该论文的结果表明,使用人类偏好来微调大型语言模型库显著改善模型在广泛任务上的表现,即使仍有许多工作要做以提升安全性和可靠性。该论文的其余部分结构如下:

首先在第3节详细介绍相关工作,然后在第4节深入研究该论文的方法和实验细节,包括该论文的高级方法(4.1),数据集和任务(4.2和4.3),人工数据收集(4.4),如何训练模型(4.5)以及评估过程(4.6)。

然后,在第5节中展示结果,分为三个部分:API提示分布的结果(5.1),公开NLP数据集的结果(5.2)和定性结果(5.3)。

最后,在第6节对该论文的工作进行了扩展讨论,包括对齐研究的影响(6.1),对齐的对象(6.2),局限性(6.3),开放性问题(6.4)以及这项工作的更广泛影响(6.5)。

3. 相关工作

关于从人类反馈中学习和对齐的研究。该论文建立在先前的技术基础上,使模型与人类意图保持一致,特别是从人类反馈中强化学习(RLHF)。这项技术最初开发用于在模拟环境和Atari游戏中训练简单的机器人(Christiano等人,2017;Ibarz等人,2018),最近被用于微调语言模型来总结文本(Ziegler等人,2019;Stiennon等人,2020;Böhm等人,2019;Wu等人,2021)。这项工作反过来又受到使用人类反馈作为奖励的领域的类似工作的影响,涉及对话(Jaques等人,2019;Yi等人,2019;Hancock等人,2019),翻译(Kreutzer等人,2018;Bahdanau等人,2016年)、语义解析(Lawrence和Riezler,2018年)、故事生成(Zhou和Xu, 2020年)、评论生成(Cho等人,2018年)和证据提取(Perez等人,2019年)等。Madaan等人(2022)使用书面的人类反馈来增强“提示”,并提高GPT-3的性能。也有一些研究使用强化学习和规范先验(Nahian等人,2021)来对齐基于文本的环境中的智能体。该论文的工作可以看作是将RLHF直接应用于对齐广泛分布的语言任务上的模型。

“语言模型对齐的含义”这个问题最近也受到了关注(Gabriel,2020)。Kenton等人(2021)在LMs中列出了由不对齐导致的行为问题,包括产生有害的内容和玩弄错误指定的目标。在同时进行的研究工作中,Askell等人(2021)提出将语言助手作为对齐研究的测试平台,研究一些简单的基线及其缩放性质。

训练语言模型遵循指令。该论文的工作还涉及语言模型跨任务的泛化研究,其中LMs在广泛的公开NLP数据集上进行微调(通常以适当的指令作为前缀),并在不同的NLP任务集上进行评估。在这一领域已经有了一系列的工作(Yi等人,2019;Mishra等人,2021;Wei等,2021;Khashabi等人,2020;Sanh等,2021;Aribandi等人,2021),它们在训练和评估数据、指令格式、预训练模型的大小和其他实验细节上有所不同。研究一致的发现是,在一系列NLP任务上,通过指令对LMs进行微调,可以提高它们在留出任务上的下游性能,无论是在零样本设置还是在少样本设置下。还有一个与可控性指令遵循相关的工作,其中训练模型遵循自然语言指令在模拟环境中的可控性(Bahdanau等人,2018;Abramson等人,2020;Zhao等,2021)。

评估语言模型的危害。修改语言模型的行为的一个目标是将这些模型部署到现实世界中时要减轻它们的危害。这些风险已被广泛记录(Bender等人,2021;Bommasani等人,2021;Kenton等人,2021;Weidinger等人,2021;Tamkin等人,2021)。语言模型可以产生有偏差的输出(Dhamala等人,2021;Liang等,2021;Manela等人,2021;Caliskan等人,2017;Kirk等人,2021),泄露私人数据(Carlini等人,2021),产生错误信息(Solaiman等人,2019;Buchanan等人,2021),并被恶意使用;有关全面详细的回顾,参见Weidinger等人(2021)。在特定领域部署语言模型会带来新的风险和挑战,例如在对话系统中(Henderson等人,2018;徐等,2020;Dinan等,2019b)。目前出现了一个新兴但不断发展的领域,旨在建立基准来具体评估这些毒性,特别是围绕毒性(Gehman等人,2020年)、刻板印象(Nadeem等人,2020年)和社会偏见(Dhamala等人,2021年;Nangia等人,2020;鲁丁格等人,2018)。在这些问题上取得重大进展是困难的,因为对语言模型行为的善意干预可能会产生副作用(Welbl等人,2021;Blodgett等人,2020)。例如,由于训练数据中存在偏见的相关性,试图降低LMs毒性的努力可能会降低其从少数群体中文本建模的能力(Xu等人,2021)。

修改语言模型的行为以减轻危害。有许多方法可以改变语言模型的生成行为。Solaiman和Dennison(2021)在一个小型的、针对价值观的数据集上微调LMs,这提高了模型在问答任务的能力。Ngo等人(2021)通过删除预训练数据集中一些语言模型有高条件概率生成一组研究人员编写的触发短语的文档来过滤预训练数据集。当在这个过滤后的数据集上训练时,它们的LMs生成的有害文本更少,代价是语言建模性能略有下降。Xu等人(2020)使用多种方法来提高聊天机器人的安全性,包括数据过滤,在生成过程中阻止某些单词或字格,安全特定的控制标记(Keskar等人,2019;Dinan等人,2019a)和人在环中数据收集(Dinan等人,2019b)。其他降低LMs产生的偏见的方法包括:使用词嵌入正则化的方法(Liu等人,2019;Huang等人,2019)、数据增强的方法(Liu等人,2019;Dinan等人,2019a;Sheng等人,2019)、零空间投影,使敏感标记上的分布更加均匀的方法(Liang等人,2021)、不同的目标函数的方法(Qian等人,2019)或因果中介分析的方法(Vig等人,2020)。也有一些工作使用第二个(通常较小的)语言模型引导语言模型生成的(Dathathri等人,2019;Krause等人,2020),这一思想的变体已被应用于减少语言模型毒性(Schick等人,2021)。

4. 方法与实验细节

4.1. 高级方法

该论文遵循了Ziegler等人(2019)和Stiennon等人(2020)的方法,他们将其应用于风格延续和摘要领域。该论文从一个预训练的语言模型开始(Radford等人,2019;Brown等人,2020年;Fedus等人,2021;Rae等人,2021;Thoppilan等人,2022)、一个输入提示分布,以及一个训练有素的标注员团队(见4.4)。训练 InstructGPT 模型的步骤如下:

步骤1:收集演示数据,训练监督策略。标注员团队提供了输入提示分布上所需行为的演示(见4.2)。然后,该论文使用监督学习用这些数据对一个预训练GPT-3模型进行微调。

步骤2:收集比较数据,训练奖励模型。该论文收集了一个模型输出之间比较的数据集,其中标注员指出他们更喜欢给定输入的哪个输出。然后训练一个奖励模型来预测人类偏好的输出。

步骤3:使用PPO算法根据奖励模型优化策略。该论文使用RM的输出作为标量奖励,使用PPO算法对监督策略进行微调,以优化该奖励(Schulman等人,2017)。

步骤2和步骤3可以连续迭代;根据当前最优策略收集更多的比较数据,用于训练一个新的RM,然后再训练一个新的策略。在实践中,大部分比较数据来自监督策略,还有一些来自PPO策略。

4.2. 数据集

该论文的提示数据集主要由提交给OpenAI API的文本提示组成,特别是那些在Playground界面上使用早期版本的InstructGPT模型(通过对演示数据子集进行监督学习训练)的文本提示。使用Playground的客户在使用InstructGPT模型的时候被告知他们的数据可以用于训练更多的模型。在本文中,该论文不使用来自生产API的客户的数据。通过检查“提示”是否共享一个较长的公共前缀来启发式地去重,并将“提示”的数量限制为每个用户ID 200个。该论文还根据用户ID创建训练、验证和测试集,以便验证和测试集不包含来自训练集中数据的用户数据。为了避免模型学习可能是敏感的客户信息,该论文过滤了训练分割中所有获取个人身份信息(PII,personally identifiable information)的“提示”。

为了训练第一个InstructGPT模型,该论文要求标注员编写自己的“提示”。这是因为需要一个初始的指令类提示源来引导流程,而这类“提示”通常不会提交给API上的常规GPT-3模型。该论文团队让标注员写出如下三类提示:

a)简单:简单地要求标注员想出任意一个任务,同时确保任务足够多样;

b)少量样本:要求标签者想出一条指令,以及该指令的多个查询/响应对;

c)基于用户:在OpenAI API的等待列表应用中陈述了许多用例,要求标注员 提出与这些用例相对应的“提示”。

根据这些“提示”,该论文生成了三个不同的数据集用于微调过程:

a)SFT数据集,使用标注员演示来训练SFT模型;

b)RM数据集,使用模型输出的标注员排名来训练RM;

c)PPO数据集,没有任何人为标签,用作RLHF微调的输入。

SFT数据集包含大约13000个训练提示(来自API和标注员编写的),RM数据集有33000个训练提示(来自API和标注员编写的),PPO数据集有31000个训练提示(仅来自API)。

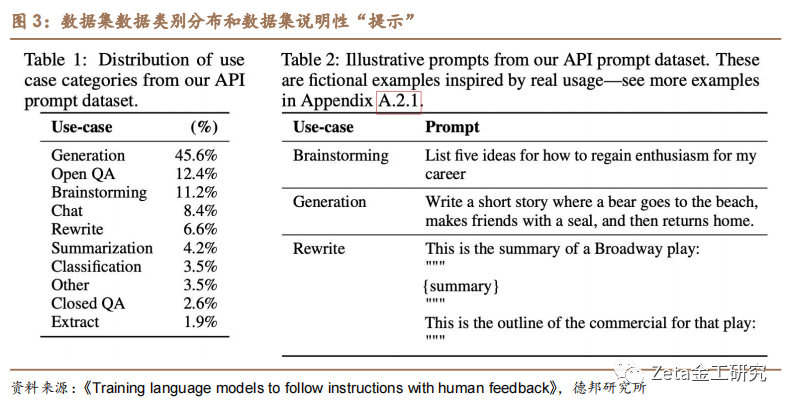

为了让该论文的数据集的组成显得更合理。如图3,该论文展示了由承包商标记的API提示(特别是RM数据集)的用例类别的分布。大多数用例都是生成的,而不是分类或QA。图3还展示了一些说明性提示(由研究人员编写,以模拟提交给InstructGPT模型的提示类型)。

4.3. 任务

该论文的训练任务有两个来源:

a)由标注员编写的提示数据集;

b)提交给API上早期InstructGPT模型的提示数据集;

这些提示非常多样化,包括生成、问题回答、对话、摘要、提取和其他自然语言任务(见图3)。该论文的数据集超过96%是英语,但是在4.3节中也探测了该论文的模型响应其他语言的指令和完成编码任务的能力。

对于每个自然语言提示,任务通常是直接通过自然语言指令指定的(例如“写一个关于一只聪明的青蛙的故事”),但也可以间接地通过几个例子(例如“给出两个青蛙故事的例子,并提示模型生成一个新的例子”)或隐式续写(例如“提供一个关于青蛙的故事的开头”)。在每种情况下,都要求标注员尽最大努力推断编写提示的用户的意图,并要求他们在任务非常不清楚情况下跳过输入。此外,标注者还会根据提供给他们的说明和他们的最佳判断,考虑隐含意图(如回答的真实性)以及潜在的有害输出(如偏见或有害的语言)。

4.4. 人工数据收集

为了产生该论文的演示和比较数据并进行主要评估,该论文团队在Upwork和ScaleAI上雇佣了大约40名承包商。与早期收集关于总结任务的人类偏好数据的工作相比(Ziegler等人,2019;Stiennon等人,2020;Wu等人,2021),该论文的输入涵盖了更广泛的任务,偶尔可能包括有争议和敏感的话题。该论文的目标是选择一组标注员,他们对不同人群的偏好敏感,并且擅长识别潜在有害的输出。因此,该论文团队进行了筛选测试,旨在测试出在这些任务中表现良好的标注员,并选择他们。

在训练和评估过程中,该论文的对齐标准可能会发生冲突(例如,当用户请求一个可能有害的响应时)。在训练过程中,该论文优先考虑对用户的帮助(不这样做需要做出一些困难的设计决策,该论文把这些决策留给未来的工作;更多讨论见6.4)。然而,在最终的评估中,该论文要求标注员优先考虑真实性和无害性。

正如Stiennon等人(2020)所述,该论文在项目过程中与标注员密切合作。该论文团队有一个培训贴标注员的入职流程,为每个任务写详细的说明,并在共享聊天室回答标注员的问题。

作为一项初步研究,该论文也观察模型在多大程度上适用于其他标注员的偏好,该论文团队聘请了一组单独的标注员,他们不生产任何训练数据。这些标签来自相同的供应商,但没有经过筛选测试。

尽管任务很复杂,但该论文团队发现标注者之间的一致性相当高:训练标注者之间的一致性为72.6±1.5%,而非训练标注者之间的一致性为77.3±1.3%。相比之下,在Stiennon等人(2020)的总结工作中,研究人员之间的一致性为73±4%。

4.5.模型

该论文从Brown等人(2020)的GPT-3预训练语言模型开始。这些模型是在广泛分布的互联网数据上训练的,适用于广泛的下游任务,但行为特征不明确。从这些模型开始,该论文用三种不同的技术训练模型:

监督微调(SFT)。该论文使用监督学习对标签机演示中的GPT-3进行了微调。训练了16个周期,使用余弦学习率衰减,残差dropout为0.2。该论文根据验证集上的RM分数进行最终的SFT模型选择。与Wu等人(2021)类似,该论文发现SFT模型在1 epoch后就在验证损失上过拟合;然而,该论文团队发现尽管存在过拟合,但训练更多epoch对RM评分和人类偏好评分都有提高。

奖励建模(RM)。从移除最后的解嵌层的SFT模型开始,该论文训练一个模型,可以接受提示和响应,并输出标量奖励。该论文只使用了60亿RMs,因为这样可以节省大量的计算资源,还发现1750亿RM训练可能是不稳定的,因此不太适合用作RL中的值函数。在Stiennon等人(2020)中,RM在同一输入上的两个模型输出之间的比较数据集上进行训练。他们使用交叉熵损失函数,将比较结果作为标签——奖励的差异表示标注者更喜欢一种反应的对数概率。

为了加快比较收集的速度,该论文为标注员提供了K=4到K=9之间的响应来排序。这会产生

其中

是

最后,由于RM损失对奖励的变化是不变的,该论文使用偏差对奖励模型进行标准化,以便标签演示在做RL之前获得平均分数0。

强化学习(RL)。继Stiennon等人(2020)之后,该论文再次使用PPO对环境上的SFT模型进行了微调(Schulman等人,2017)。该环境是一个bandit环境,它提供一个随机的客户“提示”,并期望对提示做出回应。给定提示和回应,它会产生由奖励模型决定的奖励,并结束情节。此外,在每个令牌上添加SFT模型的每个令牌KL惩罚,以缓解奖励模型的过度优化。值函数从RM开始初始化。该论文称这些模型为“PPO”。

该论文还尝试将这些预训练梯度混合到PPO梯度中,以固定公开NLP数据集上的性能衰减。该论文称这些模型为“PPO-ptx”。在RL训练中最大化以下组合目标函数:

其中,

基线。该论文比较了PPO模型与SFT模型和GPT-3模型的性能。该论文还与当提供了少镜头前缀来“提示”GPT-3进入指令遵循模式(GPT-3-prompted)进行了比较。这个前缀加在用户指定的指令的前面。

该论文还将InstructGPT与FLAN(Wei等人,2021)和T0(Sanh等人,2021)数据集上的微调1750亿GPT-3进行了比较,这两个数据集都由各种NLP任务组成,并结合了每个任务的自然语言指令(数据集在包含的NLP数据集和使用的指令风格上有所不同)。该论文分别对大约100万个例子进行微调,并选择在验证集上获得最高奖励模型分数的检查点。

4.6. 评价

为了评估该论文的模型是如何“一致”的,首先需要澄清在这种情况下一致意味着什么。一致的定义在历史上一直是一个模糊和令人困惑的话题,有各种各样有说服力的论点(Chen等人,2021年;Leke等人,2018;Gabriel,2020)。根据Leike等人(2018)的观点,该论文团队的目标是训练根据用户意图行动的模型。更实际地说,为了该论文的语言任务,使用了类似于Askell等人(2021)的框架(他们定义了模型判断如果是有用、诚实和无害的,则它们是一致的)。

为了有所帮助,模型应该遵循指令,但也可以从几个提示或其他可解释的模式(如“Q:{question}\nA:”)推断意图。由于给定提示的意图可能是不明确或模糊的,该论文依赖于标注员的判断,主要评价指标是标注员偏好。然而,由于标注者并不是生成提示的用户,因此在用户的实际意图和标注者仅阅读提示而认为的意图之间可能存在分歧。

目前尚不清楚如何在纯生成模型中衡量诚实;这需要将模型的实际输出与它对正确输出的“信念”进行比较,由于模型是一个大黑箱,因此无法推断它的信念。相反,使用两个指标来衡量真实性——模型关于世界的陈述是否真实:(1)评估的模型在封闭域任务(“幻觉”)上编造信息的倾向,以及(2)使用TruthfulQA数据集(Lin等人,2021)。

与诚实相似,衡量语言模型的有害性也带来了许多挑战。在在大多数情况下,语言模型的是否有害取决于在现实世界中如何使用它们的输出。例如,在部署的聊天机器人上下文中,生成有害输出的模型可能是有害的,但如果用于数据增强以训练更准确的有害性检测模型,则甚至可能是有用的。在项目早期,该论文让标注员评估输出是否“潜在有害”。然而,该论文团队停止了这个做法,因为这需要太多的关于“输出最终将会被怎样使用”的猜测。

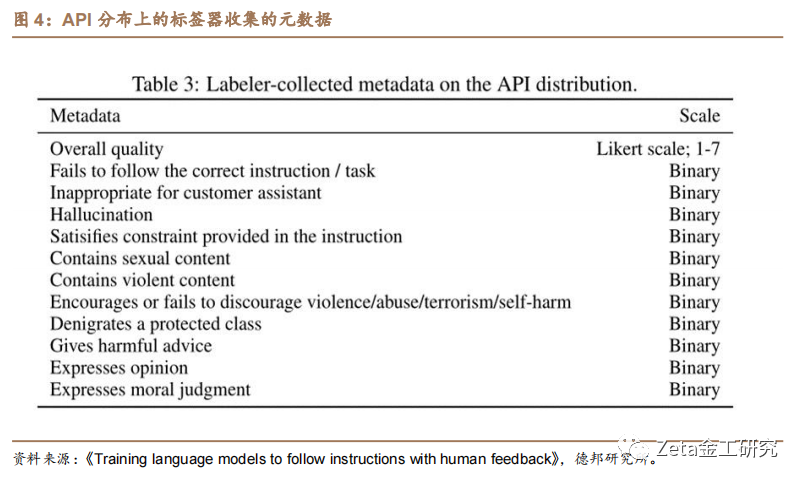

因此,该论文使用一套更具体的代理标准,旨在捕获部署模型中可能最终有害的行为的不同方面:让标注员评估输出在客户助理的上下文中是否不合适,诋毁受保护的类别,或包含性或暴力内容。还旨在测量偏差和有害性的数据集上对该论文的模型进行了基准测试,例如RealToxicityPromptss(Gehman等人,2020)和CrowS-Pairs (Nangia等人,2020)。

总之,可以把定量评估分为两个独立的部分:

对API分布的评估。主要指标是人类对来自与该论文的训练分布相同来源的一组“提示”的偏好评分。当使用API中的“提示”进行评估时,只选择未包含在培训中的客户的“提示”。然而,考虑到训练提示是设计用于InstructGPT模型的,它们很可能不利于GPT-3基线。因此,该论文也对API上提交给GPT-3模型的“提示”进行评估;这些“提示”通常不是“指令跟随”风格,而是专门为GPT-3设计的。在这两种情况下,对于每个模型,该论文计算其输出优先于基线策略的频率;该论文选择1750亿SFT模型作为基准,因为它的性能接近中等水平。此外,该论文团队要求标注员在1-7 Likert量表上判断每个响应的整体质量,并为每个模型输出收集一系列元数据。

公开NLP数据集的评估。对两种类型的公共数据集进行评估:一是捕捉语言模型安全性的一个方面,特别是真实性、有害性和偏见;二是捕捉传统NLP任务(如问答、阅读理解和总结)的零样本任务的表现。还在RealToxicityPromptss数据集上对有害性进行了人为评估(Gehman等人,2020)。

5. 结果

在本节中,该论文团队为第1节中的内容提供了实验证据,分为三部分:API“提示”分布的结果,公开NLP数据集上的结果和定性结果。

5.1. API分布上的结果

与GPT-3的输出相比,标注员明显更喜欢InstructGPT输出。该论文的“提示”测试集上,该论文团队的标注员在模型大小上明显倾向于InstructGPT输出。这些结果如图1所示。论文团队发现GPT-3输出表现最差,通过使用精心设计的少样本“提示”(GPT-3-prompted),然后使用监督学习(SFT)进行演示训练,最后使用PPO对比较数据进行训练,可以获得显著的改进。在PPO期间添加预训练混合的更新不会导致标注员偏好的大变化。为了说明该论文的增益的大小:当直接比较时,1750亿的InstructGPT输出在85±3%的时间优于GPT-3输出,在71±4%的时间优于少样本训练GPT-3输出。

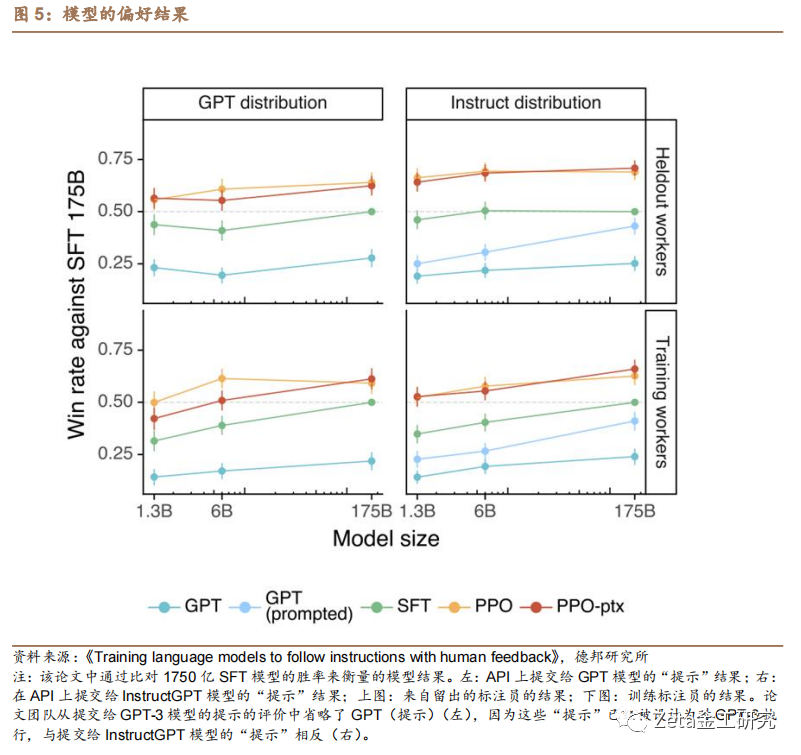

该论文团队还发现,在API上提交给GPT-3模型的“提示”上进行评估时,结果没有显著变化,如图5,尽管PPO-ptx模型在更大规模的模型上表现稍差。

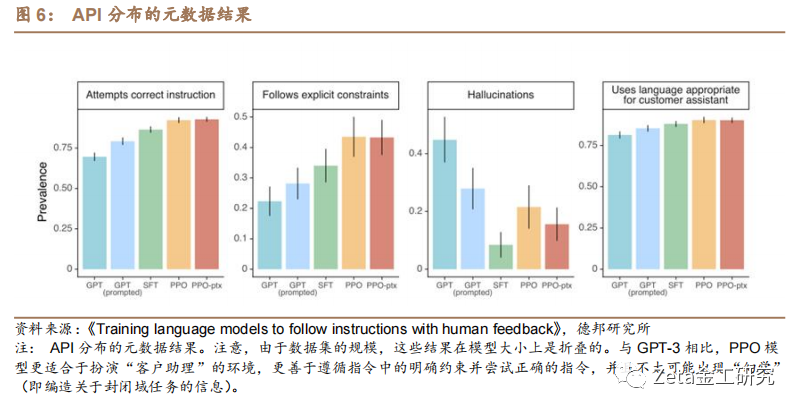

在图6中,该论文展示了标注员还沿着几个更具体的方面对InstructGPT输出进行了良好的评分。具体来说,与GPT-3相比,InstructGPT输出更适合于担任客户助理的角色,更多地遵循指令中定义的明确约束(例如“将答案写在2段或更短的范围内。”)。InstructGPT模型绝大多数情况都能完全正确地遵循指令,并且在封闭域任务中不太会编造事实。这些结果表明,InstructGPT模型比GPT-3模型更可靠,更容易控制。该论文团队找到的其他元数据类别在该论文的API中出现的频率太低,无法在该论文模型之间获得统计上的显著差异。

该论文的模型能够泛化到没有产生任何训练数据的“留出”标注员的偏好。“留出”标注员与用来生成训练数据的工作者有相似的排名偏好,如图5。根据“留出”的标注员认为所有的InstructGPT模型大大优于GPT-3基线。因此,InstructGPT模型并不是简单地过度拟合训练标注者的偏好。

从奖励模型的泛化能力中也可以看到进一步的证据。该论文进行了一个实验,将标签者分成5组,并使用5倍交叉验证(在其中4组进行训练,并在保留组进行评估)来训练5个RMs(使用3种不同的种子)。这些RMs在预测“留出”标注员偏好准确度为69.6±0.9%,与预测训练集中标注员偏好准确度72.4±0.4%相比略有下降。

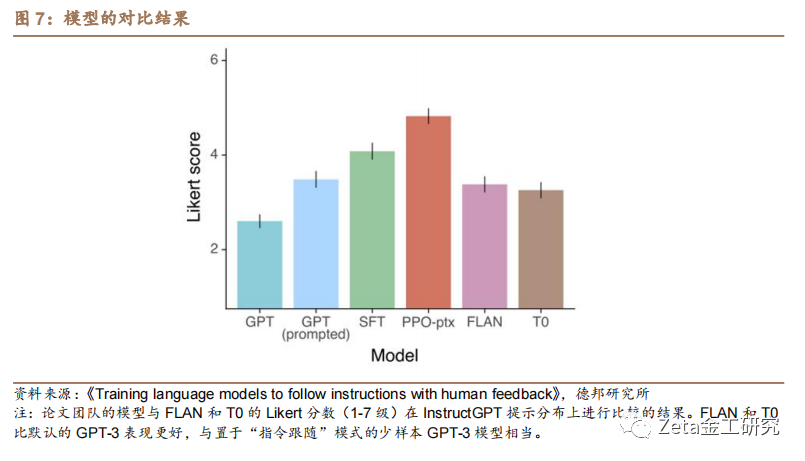

公开NLP数据集并不能反映语言模型是如何使用的。在图7中,该论文还将InstructGPT与在FLAN(Wei等人,2021)和T0(Sanh等人,2021)数据集上微调的1750亿GPT-3基线进行了比较。该论文团队发现,这些模型的表现优于GPT-3,与GPT-3在选择良好“提示”的情况下相当,但比该论文的SFT基线更差。这表明这些数据集的多样性无法提高API“提示”分布的性能。在直接的比较中,1750亿InstructGPT模型输出在78±4%的时间里优于该论文的FLAN模型,在79±4%的时间里优于论文团队的T0模型。这些模型的Likert分数如图7所示。

论文团队相信InstructGPT模型优于FLAN和T0,原因有二。首先,公开NLP数据集旨在捕获易于自动度量进行评估的任务,例如分类、问题回答,以及一定程度上的总结和翻译任务。然而,分类和QA只占客户使用语言模型的一小部分(约18%),而根据标注员的说法,开放式生成和头脑风暴占该论文“提示”数据集的57%,如图3。其次,公开NLP数据集很难获得非常多样化的输入(至少在现实世界用户感兴趣的输入类型上)。当然,在NLP数据集中发现的任务确实代表了该论文团队希望语言模型能够解决的一种指令,因此最广泛的指令跟踪模型将结合这两种类型的数据集。

5.2. 公开NLP数据集合上的结果

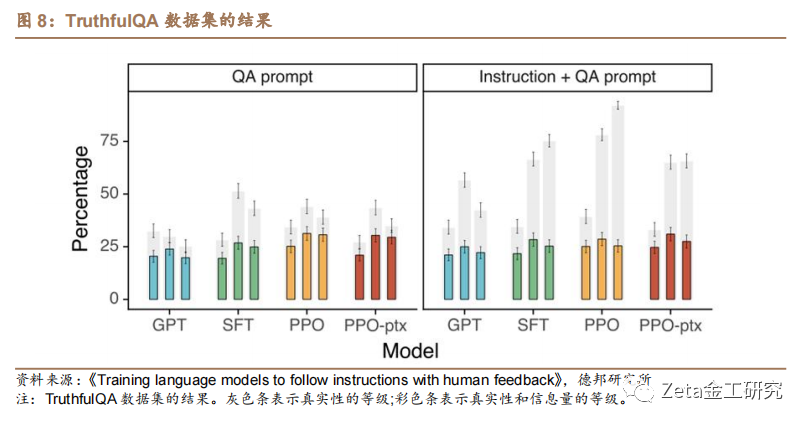

InstructGPT模型的真实性比GPT-3有所提高。根据TruthfulQA数据集上的人类评估的衡量结果,与GPT-3相比,该论文的PPO模型在生成真实和丰富的输出方面具有小量但是显著的改进,如图8。这种行为是默认的——论文团队的模型不需要被特别指示说真话来显示提高的真实性。有趣的是,论文团队的13亿PPO-ptx模型是个例外,它的性能略差于相同大小的GPT-3模型。当在不是与GPT-3对抗性选择的“提示”上进行评估时,PPO模型仍然明显比GPT-3更真实和丰富(尽管绝对改进下降了几个百分点)。

继Lin等人(2021)之后,该论文还给出了一个有用的“指令+QA”提示,用来指示模型在不确定正确答案时以“我没有意见”回应。在这种情况下,PPO模型更倾向于诚实和无信息,而不是自信地说出一个错误;基准GPT-3模型在这方面做得并不好。

在真实性方面的改进也可以通过以下事实得到证明:PPO 模型在 API 分布的封闭域任务上产生幻觉(即伪造信息)的频率较低,如图6。

InstructGPT的毒性比GPT-3略有改善,但偏差不大。该论文团队首先在RealToxicityPrompts数据集上评估该论文模型(Gehman等人,2020)。通过两种方式来做到这一点:前者一个标准的数据集评估流程,通过Perspective API运行模型样本来自动获得毒性评分;后者,将这些样本发送给标注员以获得绝对毒性、相对于“提示”的毒性、连续性和总体输出偏好的评级。根据“提示”有毒性,该论文从这个数据集中统一采样“提示”,以更好地评估该论文团队的模型在高输入毒性下的表现;这与该数据集上标准的采样“提示”不同,因此该论文绝对毒性数字被夸大了。

结果如图9所示。该论文团队发现,当被指示产生安全且尊重的输出(“尊重的提示”)时,根据Perspective API,InstructGPT模型产生的有毒输出比GPT-3模型产生的更少。当“尊重的提示”被移除(无提示)时,这种优势就消失了。有趣的是,当显式提示产生有毒的输出时,InstructGPT输出比GPT-3的输出有毒得多。这些结果在人类评估中得到了证实:在“尊重的提示”设置中,InstructGPT的有毒性小于GPT-3,但在“无提示”设置中表现相似。

为了评估模型生成有偏见言论的倾向,该论文还在Winogender (Rudinger 等人,2018)和CrowS-Pairs (Nangia 等人,2020)数据集的修改版本上评估了InstructGPT。这些数据集由成对的句子组成,可以突出潜在的偏见。该论文计算产生每对句子的相对概率和相关二进制概率分布的熵(以比特为单位)。完全无偏的模型将在每对句子之间没有偏好,因此将具有最大的熵。根据这个指标,该论文的模型的偏差并不比GPT-3少。PPO-ptx模型显示出与GPT-3相似的偏差,但当被指示产生尊重行为时,它表现出更低的熵,因此具有更高的偏差。偏差的模式尚不清楚;似乎被指示的模型对它们的输出更确定,不管它们的输出是否表现出刻板的行为。

可以通过修改RLHF微调过程来最小化公开NLP数据集上的性能衰减。默认情况下,当该论文团队在API分布上训练PPO模型时,它会受到“对齐税”的影响,因为它在几个公开NLP数据集上的性能会下降。该论文团队想要一个避免对齐税的对齐过程,因为它鼓励使用未对齐但是更有能力的模型。

5.3. 定性结果

InstructGPT模型对RLHF微调分布之外的指令显示出很好的泛化效果。特别地,该论文团队发现InstructGPT显示了遵循非英语语言指令的能力,以及对代码进行总结和回答问题的能力。这很有趣,因为非英语语言和代码在论文团队的微调数据中只占很小一部分,这表明,在某些情况下,对齐方法可以推广到对人类没有直接监督的输入。

该论文没有定量地记录这些行为,但是该论文在图10中显示了一些定性的例子。该论文的1750亿PPO-ptx模型能够可靠地回答有关代码的问题,也可以遵循其他语言的说明;然而,该论文团队注意到,即使指令是另一种语言,它也经常产生英语输出。相比之下,论文团队发现GPT-3可以执行这些任务,但需要更仔细的“提示”,并且很少遵循这些领域的指示。

InstructGPT仍然会犯简单的错误。在1750亿PPO-ptx模型交互时,论文团队注意到它仍然会犯一些简单的错误,尽管它在许多不同的语言任务上表现出色。举几个例子:(1)当给出一个带有错误前提的指令时,模型有时会错误地假设前提为真;(2)模型可能会拐弯抹角;当给出一个简单的问题时,它有时会说这个问题没有一个答案,并给出多个可能的答案,即使从上下文中有一个相当明确的答案;(3)当指令包含多个明确的约束条件(例如“列出10部1930年代在法国拍摄的电影”)或当约束条件对语言模型具有挑战性时,模型的性能会下降(例如,用指定的句子数写一篇总结)。

该论文在图11中展示了这些行为的一些例子。该论文团队怀疑行为(2)的出现部分是因为该论文团队要求标注员奖励谦逊的行为;因此,他们可能倾向于奖励那些避免直接回答的输出,而这被奖励模型所选择。该论文团队怀疑行为(1)的发生是因为训练集中很少有假设错误前提的提示,而且模型不能很好地推广到这些例子。该论文团队认为,通过收集对抗性数据可以显著减少这两种行为(Dinan等人,2019b)。

6. 讨论

6.1. 对齐研究的影响

本研究是该论文团队更广泛的研究计划的一部分,该计划旨在使人工智能系统与人类意图保持一致(Christiano等人,2017;Ziegler等人,2019年;Stiennon等人,2020)。尽管这项工作的重点是该论文团队当前的语言模型系统,但该论文团队寻求适用于未来AI系统的通用和可扩展方法(Leike等人,2018)。该论文团队在这里使用的系统仍然相当有限,但它们是当今最大的语言模型之一,该论文团队将它们应用于广泛的语言任务,包括分类、总结、问答、创意写作、对话等。

该论文在这项工作中的对齐研究方法是迭代的:该论文团队正在改进当前AI系统的对齐,而不是抽象地专注于对齐尚不存在的AI系统。这种方法的一个缺点是,该论文团队不会直接面对只有在对齐超人类的系统时才会出现的对齐问题(Bostrom, 2014)。然而,该论文确实提供了一个明确的经验反馈循环方法,给出哪些有效、哪些无效。该论文团队相信,这种反馈循环对改进对齐技术至关重要,它迫使研究者跟上机器学习的进步。此外,该论文在这里使用的对齐技术RLHF是几篇关于对齐超人类系统文献提出的方法的重要部分(Leike等人,2018;Irving等人,2018;Christiano等人,2018)。例如,RLHF是最近总结书籍任务的核心方法,该任务展示了对齐超人类的AI系统的一些困难,因为人类很难直接评估(Wu等人,2021年)。

从本工作中,该论文团队可以为更普遍的对齐研究提供借鉴:

1.与预训练相比,增加模型对齐的成本是适度的。收集数据和计算训练运行(包括实验运行)的成本是训练GPT-3花费的一小部分:训练1750亿SFT模型需要4.9 petaflops/s-天,训练1750亿PPO-ptx模型需要60 petaflops/s-天,而GPT-3则需要3640 petaflops/s-天(Brown等人,2020)。与此同时,该论文团队的结果表明,RLHF在使语言模型对用户更有帮助方面非常有效,比模型大小增加100倍还有效。这表明,目前增加对现有语言模型的投资比训练更大的模型更具性价比——至少对于该论文团队客户的自然语言任务分布而言是这样。

2.该论文已经看到一些证据表明,InstructGPT将“遵循指令”推广到该论文团队不监督它的设置中,例如非英语语言任务和与代码相关的任务。这是一个重要的属性,因为让人类监督模型执行的每一项任务的成本非常高。需要更多的研究来研究这种泛化如何随着能力的增加而扩展;关于这一方向的最新研究,请参见Christiano等人(2021)。

3.该论文能够减轻大部分由微调带来的性能下降。如果不是这样,这些性能下降将构成对齐税——对齐模型的额外成本。任何高税收的技术可能都不会被采用。为了避免造成未来高性能AI系统与人类意图不一致,需要具有低对齐税的对齐技术。为此,该论文团队的结果对于RLHF作为一种低税对齐技术来说是一个好消息。

4.该论文团队已经在现实世界的研究中验证了对齐技术。对齐研究历来相当抽象,专注于理论结果(Soares等人,2015)和少的人工合成领域(Christiano等人,2018;Leike等人,2017),或在公开NLP数据集上训练机器学习ML(Machine Learning,以下简称ML)模型(Ziegler等人,2019;Stiennon等人,2020)。该论文团队的工作为在现实生活有顾客的生产环境中AI系统的对齐研究提供了基础。这就为技术的有效性和局限性提供了一个重要的反馈循环。

6.2. 在向谁对齐

当将语言模型与人类意图对齐时,它们的最终行为是底层模型(及其训练数据)、微调数据和使用的对齐方法的函数。在本节中,该论文团队将具体描述一些影响微调数据的因素以最终确定要对齐的对象。然后,在第6.3节讨论工作的局限性之前,会考虑需要改进的地方。

文献经常使用诸如“人类偏好”或“人类价值观”之类的术语来构建一致性。在这项工作中,该论文团队与标注员的偏好保持一致,这些偏好受到他们所得到的指示、他们收到这些指示的环境(作为一份有偿工作)以及他们收到这些指示的人的影响。一些关键的注意事项有:

首先,该论文团队旨在对齐训练标注员提供的演示和偏好,标注员直接生成该论文中用于微调模型的数据。该论文团队通过Upwork和Scale AI聘用的标注员大多生活在美国或东南亚,并以英语为母语。他们在许多标注案例上意见不一,标注员达成一致的数据约为73%。

其次,作为设计这项研究的研究人员(同时作为更大研究组织OpenAI的代理人员),该论文团队对齐于自身的偏好:该论文团队编写的标签说明作为标注员在完成演示和选择偏好输出时的指南以及该论文团队在共享聊天室中回答他们关于前言情形的问题。不同的指令集和界面设计对标注员收集数据及模型行为的最终影响还需要更多的研究。

第三,该论文团队的训练数据是由OpenAI客户发送给OpenAI API Playground上的模型的“提示”决定的,因此该论文团队隐式地与客户认为有价值的东西以及他们的最终用户认为使用API有价值的东西(在某些情况下)保持对齐。客户和他们的最终用户可能不同意,或者客户可能没有为最终用户进行优化;例如,客户可能想要一个能够最大化用户在其平台上花费时间的模型,这并不一定是最终用户想要的。在实践中,该论文团队的标注员无法看到给定“提示”或补全所处的上下文。

第四,OpenAI的客户不能代表语言模型的所有潜在或当前用户,更不能代表所有受语言模型使用影响的个人和群体。在这个项目的大部分时间里,OpenAI API的用户都是从等待列表中选择出来的。这个最初的种子用户名单是OpenAI的员工以及偏向于该论文团队社交网络的群体。

退一步说,设计一个公平、透明、有适当问责机制的对齐过程有许多困难。本文的目标是证明这种对齐技术可以对准特定应用的特定人群。该论文团队并不是说研究人员、雇佣的标注员或API客户是正确的偏好来源。需要考虑许多利益相关者——训练模型的组织、使用模型开发产品的客户、这些产品的最终用户,以及可能直接或间接受到影响的更广泛的人群。这不仅是一个使对齐过程更具参与性的问题;不可能训练出一个系统,让它立刻与每个人的偏好保持一致,或者让每个人都认可这种取舍。

一个可能的改进方向是训练模型使模型可以依赖于特定群体的偏好,或者可以很容易地微调或提示来代表不同的群体。不同的模型可以被认可不同价值观的团队部署和使用。然而,这些模式最终可能仍会影响到更广泛的社会,需要做出许多艰难的决定,包括以谁的偏好为条件,以及如何确保所有群体都能得到代表,并去除可能有害的过程。

6.3. 局限性

6.3.1. 方法论

该论文团队的InstructGPT模型的部分行为是从标注员获得的人类反馈决定的。一些标签任务依赖于价值判断,这可能会受到标注员的身份、信仰、文化背景和个人身世的影响。该论文团队雇佣了大约40个标注员,根据他们在筛选测试中的表现来判断他们识别和响应敏感“提示”的能力以及他们与带有详细说明标签任务上的一致率。该论文团队控制了自己的标注员团队的规模,认为这有利于标注员和论文团队之间高效率交流。然而,这个群体显然不能代表使用模型和受模型影响的所有人群。举个简单的例子,该论文团队的标注员主要以英语为母语,使用数据的语言也基本是英语。

该论文团队还可以通过许多方法来改进数据收集步骤。例如,由于成本原因,大多数的比较只由一个标注员标记。多次标记示例可以帮助确定标注员不一致的地方,但在这些地方单个模型不太可能与所有模型一致。在不一致的情况下,调整到平均标注员的偏好可能是不可取的。例如,当生成小比例的少数群体的文本时,该论文团队可能希望给予这类标注员更多的权重。

6.3.2. 模型

该论文模型既没有完全对齐,也不是绝对安全;它们仍然产生有害或有偏见的输出以及编造事实。它们也可能无法在某些输入上生成合理的输出;该论文团队在图9中展示了一些这样的例子。

也许模型最大的限制是,在大多数情况下,它们会遵循用户的指示,即使这可能会在现实中造成伤害。例如,当给出指示模型最极端的“提示”时,InstructGPT产生的有害输出比同等规模的GPT-3模型更多。该论文团队将在以下部分讨论可能的缓解方法。

6.4. 开放性问题

这项工作是使用对齐技术微调语言模型以遵循广泛指令研究方向的第一步。为了进一步使语言模型行为与人们实际希望它们做的事情相一致,还有许多开放性问题有待探索。

可以尝试许多方法来进一步减少模型不当输出、有偏见输出和其他有害输出的倾向。例如,可以使用对抗性设置,其中标注员找到模型的最坏情况行为,然后标记并添加到数据集(Dinan等人,2019b)。也可以将该论文的方法与过滤预训练数据的方法结合起来(Ngo等人,2021年),用于训练初始预训练模型,或用于该论文的预训练混合方法中使用的数据。同样,可以将该论文的方法与提高模型真实性的方法结合起来,例如WebGPT (Nakano等人,2021)。

在这项工作中,如果用户请求一个潜在的有害或不诚实的响应,允许模型生成这些输出。训练模型不受用户指令的影响是很重要的,但也很困难,因为输出是否有害取决于它所部署的上下文。该论文的技术还可以应用于让模型拒绝某些用户指令,并计划在本研究的后续迭代中探索这一点。

让模型做想做的事情与可控性文献直接相关(Dathathri等人,2019;Krause等人,2020)。一个有前途的未来路径是将RLHF与其他可控性方法结合起来,例如使用控制代码(Keskar等人,2019),或在推理时使用较小的模型修改采样程序(Dathathri等人,2019)。

虽然该论文团队主要关注RLHF,但还有许多其他算法可以用于在该论文的演示和比较数据上训练策略,以获得更好的结果。例如,可以探索专家迭代(Anthony等人,2017;Silver等人,2017),或者使用比较数据子集的更简单的行为克隆方法。人们也可以尝试约束优化方法(Achiam等人,2017),以产生少量有害行为为条件,最大化奖励模型的分数。比较也不一定是提供对齐信号的最有效方法。例如,可以让标注员编辑模型响应以使其更好,或者用自然语言生成模型响应的评论。在为标注员设计接口以向语言模型提供反馈方面,还有很大的选择空间;这是一个有趣的人机交互问题。

该论文团队提出的通过将训练前数据合并到RLHF微调中来减轻对齐税的建议,并没有完全减轻性能衰减,并且可能会使某些不希望的行为更有可能在某些任务中出现(如果这些行为存在于预训练数据中)。这是个值得进一步研究的有趣领域。另一种可能改进这篇论文的方法是过滤预训练混合数据中的有害内容(Ngo等人,2021年),或使用合成指令增强这些数据。

正如Gabriel(2020)中详细讨论的那样,在调整指令、意图、揭示的偏好、理想偏好、兴趣和价值观之间存在微妙的差异。Gabriel(2020)倡导以原则为基础的对齐方法:换句话说,确定“无论人们的道德信仰存在多么广泛的差异,但都能获得反映和认可的公平对齐原则”。在该论文中,为了简单起见,该论文团队与推断的用户意图保持一致,但在这一领域还需要更多的研究。事实上,最大的开放问题之一是如何设计一个透明的对齐过程,它有意义地代表受技术影响的人,并以一种多群体中达成广泛共识的方式综合人们的价值观。

6.5. 更广泛的影响

该论文的动机是通过训练大型语言模型去做一组人类想让它们做的事情,来增加大型语言模型的积极影响。默认情况下,语言模型优化下一个单词预测目标,这只是人们想让这些模型做什么的代理目标。结果表明,该论文技术有望使语言模型更有帮助、更真实、更无害。从长远来看,对齐失败可能会导致更严重的后果,特别是在这些模型部署在安全非常重要的情形。该论文团队预计,随着模型的继续扩展,必须更加谨慎地确保它们与人类的意图保持一致(Bostrom,2014)。

然而,让语言模型更好地遵循用户意图也会使它们更容易被误用。使用这些模型可能更容易产生令人信服的错误信息,或仇恨或辱骂内容。

对齐技术不是解决与大型语言模型相关的安全问题的灵丹妙药;相反,它们应该被用作更广泛的安全生态系统中的一种工具。除了故意误用之外,在许多领域中,大型语言模型的部署都应该非常小心,也可能根本不需要。例如,高风险领域,如医疗诊断,根据受保护的特征对人进行分类,确定信贷、就业或住房的资格,制作政治广告和执法。如果这些模型是开源的,在没有监管的情况下,限制不同领域的有害应用就变得十分困难。另一方面,如果大型语言模型的获得被限制在少数拥有训练所需资源的组织中,这将使大多数人无法访问尖端的机器学习技术。对于组织来讲,另一种选择是拥有端到端模型部署的基础设施,并通过API访问它。这允许实现安全协议,如用例限制(只允许模型用于某些应用程序),监控滥用和停止那些滥用系统的人的访问,以及限制速率以防止大规模错误信息的产生。这些限制会交给API提供商来最后决定,可能以降低透明度和增加集权为代价。最后,正如6.2节所讨论的,这些模型与谁对齐的问题是极其重要的,并且将显著影响这些模型到底是积极的还是消极的。

7. 风险提示

数据不完备和滥用风险,信息安全风险,算法伦理风险。

8. 参考文献

[1].Abramson, J., Ahuja, A., Barr, I., Brussee, A., Carnevale, F., Cassin, M., Chhaparia, R., Clark, S., Damoc, B., Dudzik, A., et al. (2020). Imitating interactive intelligence. arXiv preprint arXiv:2012.05672.

[2].Achiam, J., Held, D., Tamar, A., and Abbeel, P. (2017). Constrained policy optimization. In International Conference on Machine Learning, pages 22–31. PMLR.

[3].Anthony, T., Tian, Z., and Barber, D. (2017). Thinking fast and slow with deep learning and tree search. arXiv preprint arXiv:1705.08439.

[4].Aribandi, V., Tay, Y., Schuster, T., Rao, J., Zheng, H. S., Mehta, S. V., Zhuang, H., Tran, V. Q., Bahri, D., Ni, J., et al. (2021). Ext5: Towards extreme multi-task scaling for transfer learning. arXiv preprint arXiv:2111.10952.

[5].Askell, A., Bai, Y., Chen, A., Drain, D., Ganguli, D., Henighan, T., Jones, A., Joseph, N., Mann, B., DasSarma, N., et al. (2021). A general language assistant as a laboratory for alignment. arXiv preprint arXiv:2112.00861.

[6].Bahdanau, D., Brakel, P., Xu, K., Goyal, A., Lowe, R., Pineau, J., Courville, A., and Bengio, Y. (2016). An actor-critic algorithm for sequence prediction. arXiv preprint arXiv:1607.07086.

[7].Bahdanau, D., Hill, F., Leike, J., Hughes, E., Hosseini, A., Kohli, P., and Grefenstette, E. (2018). Learning to understand goal specifications by modelling reward. arXiv preprint arXiv:1806.01946.

[8].Bender, E. M., Gebru, T., McMillan-Major, A., and Shmitchell, S. (2021). On the dangers of stochastic parrots: Can language models be too big? In Proceedings of the 2021 ACM Conference on Fairness, Accountability, and Transparency, pages 610–623.

[9].Blodgett, S. L., Barocas, S., Daumé III, H., and Wallach, H. (2020). Language (technology) is power: A critical survey of" bias" in nlp. arXiv preprint arXiv:2005.14050.

[10].Böhm, F., Gao, Y., Meyer, C. M., Shapira, O., Dagan, I., and Gurevych, I. (2019). Better rewards yield better summaries: Learning to summarise without references. arXiv preprint arXiv:1909.01214.

[11].Bojar, O., Chatterjee, R., Federmann, C., Haddow, B., Huck, M., Hokamp, C., Koehn, P., Logacheva, V., Monz, C., Negri, M., Post, M., Scarton, C., Specia, L., and Turchi, M. (2015). Findings of the 2015 workshop on statistical machine translation. In Proceedings of the Tenth Workshop on Statistical Machine Translation, pages 1–46, Lisbon, Portugal. Association for Computational Linguistics.

[12].Bommasani, R., Hudson, D. A., Adeli, E., Altman, R., Arora, S., von Arx, S., Bernstein, M. S., Bohg, J., Bosselut, A., Brunskill, E., et al. (2021). On the opportunities and risks of foundation models. arXiv preprint arXiv:2108.07258.

[13].Bostrom, N. (2014). Superintelligence. Dunod.

[14].Brown, T. B., Mann, B., Ryder, N., Subbiah, M., Kaplan, J., Dhariwal, P., Neelakantan, A., Shyam, P., Sastry, G., Askell, A., et al. (2020). Language models are few-shot learners. arXiv preprint arXiv:2005.14165.

[15].Buchanan, B., Lohn, A., Musser, M., and Sedova, K. (2021). Truth, lies, and automation. Technical report, Center for the Study of Emerging Technology.

[16].Caliskan, A., Bryson, J. J., and Narayanan, A. (2017). Semantics derived automatically from language corpora contain human-like biases. Science, 356(6334):183–186.

[17].Carlini, N., Tramer, F., Wallace, E., Jagielski, M., Herbert-Voss, A., Lee, K., Roberts, A., Brown, T., Song, D., Erlingsson, U., et al. (2021). Extracting training data from large language models. In 30th USENIX Security Symposium (USENIX Security 21), pages 2633–2650.

[18].Chen, M., Tworek, J., Jun, H., Yuan, Q., Pinto, H. P. d. O., Kaplan, J., Edwards, H., Burda, Y., Joseph, N., Brockman, G., et al. (2021). Evaluating large language models trained on code. arXiv preprint arXiv:2107.03374.

[19].Cho, W. S., Zhang, P., Zhang, Y., Li, X., Galley, M., Brockett, C., Wang, M., and Gao, J. (2018). Towards coherent and cohesive long-form text generation. arXiv preprint arXiv:1811.00511.

[20].Choi, E., He, H., Iyyer, M., Yatskar, M., Yih, W.-t., Choi, Y., Liang, P., and Zettlemoyer, L. (2018). Quac: Question answering in context. In Proceedings of the 2018 Conference on Empirical Methods in Natural Language Processing, pages 2174–2184.

[21].Christiano, P., Cotra, A., and Xu, M. (2021). Eliciting latent knowledge: How to tell if your eyes deceive you. https://www.alignmentforum.org/posts/qHCDysDnvhteW7kRd/arc-s-first-technical- report-eliciting-latent-knowledge.

[22].Christiano, P., Shlegeris, B., and Amodei, D. (2018). Supervising strong learners by amplifying weak experts. arXiv preprint arXiv:1810.08575.

[23].Christiano, P. F., Leike, J., Brown, T., Martic, M., Legg, S., and Amodei, D. (2017). Deep reinforce- ment learning from human preferences. In Advances in Neural Information Processing Systems, pages 4299–4307.

[24].Dathathri, S., Madotto, A., Lan, J., Hung, J., Frank, E., Molino, P., Yosinski, J., and Liu, R. (2019). Plug and play language models: A simple approach to controlled text generation. arXiv preprint arXiv:1912.02164.

[25].Dhamala, J., Sun, T., Kumar, V., Krishna, S., Pruksachatkun, Y., Chang, K.-W., and Gupta, R. (2021). Bold: Dataset and metrics for measuring biases in open-ended language generation. In Proceedings of the 2021 ACM Conference on Fairness, Accountability, and Transparency, pages 862–872.

[26].Dinan, E., Fan, A., Williams, A., Urbanek, J., Kiela, D., and Weston, J. (2019a). Queens are powerful too: Mitigating gender bias in dialogue generation. arXiv preprint arXiv:1911.03842.

[27].Dinan, E., Humeau, S., Chintagunta, B., and Weston, J. (2019b). Build it break it fix it for dialogue safety: Robustness from adversarial human attack. arXiv preprint arXiv:1908.06083.

[28].Dua, D., Wang, Y., Dasigi, P., Stanovsky, G., Singh, S., and Gardner, M. (2019). Drop: A read- ing comprehension benchmark requiring discrete reasoning over paragraphs. arXiv preprint arXiv:1903.00161.

[29].Fedus, W., Zoph, B., and Shazeer, N. (2021). Switch transformers: Scaling to trillion parameter models with simple and efficient sparsity. arXiv preprint arXiv:2101.03961.

[30].Gabriel, I. (2020). Artificial intelligence, values, and alignment. Minds and machines, 30(3):411–437. Gehman, S., Gururangan, S., Sap, M., Choi, Y., and Smith, N. A. (2020). Realtoxicityprompts:

[31].Evaluating neural toxic degeneration in language models. arXiv preprint arXiv:2009.11462. Hancock, B., Bordes, A., Mazare, P.-E., and Weston, J. (2019). Learning from dialogue after

[32].deployment: Feed yourself, chatbot! arXiv preprint arXiv:1901.05415.

[33].Henderson, P., Sinha, K., Angelard-Gontier, N., Ke, N. R., Fried, G., Lowe, R., and Pineau, J. (2018). Ethical challenges in data-driven dialogue systems. In Proceedings of the 2018 AAAI/ACM Conference on AI, Ethics, and Society, pages 123–129.

[34].Huang, P.-S., Zhang, H., Jiang, R., Stanforth, R., Welbl, J., Rae, J., Maini, V., Yogatama, D., and Kohli, P. (2019). Reducing sentiment bias in language models via counterfactual evaluation. arXiv preprint arXiv:1911.03064.

[35].Ibarz, B., Leike, J., Pohlen, T., Irving, G., Legg, S., and Amodei, D. (2018). Reward learning from human preferences and demonstrations in atari. In Advances in neural information processing systems, pages 8011–8023.

[36].Irving, G., Christiano, P., and Amodei, D. (2018). AI safety via debate. arXiv preprint arXiv:1805.00899.

[37].Jaques, N., Ghandeharioun, A., Shen, J. H., Ferguson, C., Lapedriza, A., Jones, N., Gu, S., and Picard, R. (2019). Way off-policy batch deep reinforcement learning of implicit human preferences in dialog. arXiv preprint arXiv:1907.00456.

[38].Kenton, Z., Everitt, T., Weidinger, L., Gabriel, I., Mikulik, V., and Irving, G. (2021). Alignment of language agents. arXiv preprint arXiv:2103.14659.

[39].Keskar, N. S., McCann, B., Varshney, L. R., Xiong, C., and Socher, R. (2019). Ctrl: A conditional transformer language model for controllable generation. arXiv preprint arXiv:1909.05858.

[40].Khashabi, D., Min, S., Khot, T., Sabharwal, A., Tafjord, O., Clark, P., and Hajishirzi, H. (2020). Uni- fiedqa: Crossing format boundaries with a single qa system. arXiv preprint arXiv:2005.00700.

[41].Kirk, H., Jun, Y., Iqbal, H., Benussi, E., Volpin, F., Dreyer, F. A., Shtedritski, A., and Asano, Y. M. (2021). How true is gpt-2? an empirical analysis of intersectional occupational biases. arXiv preprint arXiv:2102.04130.

[42].Krause, B., Gotmare, A. D., McCann, B., Keskar, N. S., Joty, S., Socher, R., and Rajani, N. F. (2020). Gedi: Generative discriminator guided sequence generation. arXiv preprint arXiv:2009.06367.

[43].Kreutzer, J., Khadivi, S., Matusov, E., and Riezler, S. (2018). Can neural machine translation be improved with user feedback? arXiv preprint arXiv:1804.05958.

[44].Lawrence, C. and Riezler, S. (2018). Improving a neural semantic parser by counterfactual learning from human bandit feedback. arXiv preprint arXiv:1805.01252.

[45].Leike, J., Krueger, D., Everitt, T., Martic, M., Maini, V., and Legg, S. (2018). Scalable agent alignment via reward modeling: a research direction. arXiv preprint arXiv:1811.07871.

[46].Leike, J., Martic, M., Krakovna, V., Ortega, P. A., Everitt, T., Lefrancq, A., Orseau, L., and Legg, S. (2017). AI safety gridworlds. arXiv preprint arXiv:1711.09883.

[47].Liang, P. P., Wu, C., Morency, L.-P., and Salakhutdinov, R. (2021). Towards understanding and mitigating social biases in language models. In International Conference on Machine Learning, pages 6565–6576. PMLR.

[48].Lin, S., Hilton, J., and Evans, O. (2021). Truthfulqa: Measuring how models mimic human falsehoods. arXiv preprint arXiv:2109.07958.

[49].Liu, H., Dacon, J., Fan, W., Liu, H., Liu, Z., and Tang, J. (2019). Does gender matter? towards fairness in dialogue systems. arXiv preprint arXiv:1910.10486.

[50].Madaan, A., Tandon, N., Clark, P., and Yang, Y. (2022). Memory-assisted prompt editing to improve gpt-3 after deployment. arXiv preprint arXiv:2201.06009.

[51].Manela, D. d. V., Errington, D., Fisher, T., van Breugel, B., and Minervini, P. (2021). Stereotype and skew: Quantifying gender bias in pre-trained and fine-tuned language models. arXiv preprint arXiv:2101.09688.

[52].Mishra, S., Khashabi, D., Baral, C., and Hajishirzi, H. (2021). Cross-task generalization via natural language crowdsourcing instructions. arXiv preprint arXiv:2104.08773.

[53].Nadeem, M., Bethke, A., and Reddy, S. (2020). Stereoset: Measuring stereotypical bias in pretrained language models. arXiv preprint arXiv:2004.09456.

[54].Nahian, M. S. A., Frazier, S., Harrison, B., and Riedl, M. (2021). Training value-aligned reinforcement learning agents using a normative prior. arXiv preprint arXiv:2104.09469.

[55].Nakano, R., Hilton, J., Balaji, S., Wu, J., Ouyang, L., Kim, C., Hesse, C., Jain, S., Kosaraju, V., Saunders, W., et al. (2021). Webgpt: Browser-assisted question-answering with human feedback. arXiv preprint arXiv:2112.09332.

[56].Nallapati, R., Zhou, B., Gulcehre, C., Xiang, B., et al. (2016). Abstractive text summarization using sequence-to-sequence rnns and beyond. arXiv preprint arXiv:1602.06023.

[57].Nangia, N., Vania, C., Bhalerao, R., and Bowman, S. R. (2020). CrowS-Pairs: A Challenge Dataset for Measuring Social Biases in Masked Language Models. In Proceedings of the 2020 Conference on Empirical Methods in Natural Language Processing, Online. Association for Computational Linguistics.

[58].Ngo, H., Raterink, C., Araújo, J. G., Zhang, I., Chen, C., Morisot, A., and Frosst, N. (2021). Mitigating harm in language models with conditional-likelihood filtration. arXiv preprint arXiv:2108.07790.

[59].Perez, E., Karamcheti, S., Fergus, R., Weston, J., Kiela, D., and Cho, K. (2019). Finding generalizable evidence by learning to convince q&a models. arXiv preprint arXiv:1909.05863.

[60].Qian, Y., Muaz, U., Zhang, B., and Hyun, J. W. (2019). Reducing gender bias in word-level language models with a gender-equalizing loss function. arXiv preprint arXiv:1905.12801.

[61].Radford, A., Wu, J., Child, R., Luan, D., Amodei, D., and Sutskever, I. (2019). Language models are unsupervised multitask learners. OpenAI Blog, 1(8):9.

[62].Rae, J. W., Borgeaud, S., Cai, T., Millican, K., Hoffmann, J., Song, F., Aslanides, J., Henderson, S., Ring, R., Young, S., et al. (2021). Scaling language models: Methods, analysis & insights from training gopher. arXiv preprint arXiv:2112.11446.

[63].Rajpurkar, P., Jia, R., and Liang, P. (2018). Know what you don’t know: Unanswerable questions for squad. arXiv preprint arXiv:1806.03822.

[64].Rudinger, R., Naradowsky, J., Leonard, B., and Van Durme, B. (2018). Gender bias in coreference resolution. In Proceedings of the 2018 Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies, New Orleans, Louisiana. Association for Computational Linguistics.

[65].Sanh, V., Webson, A., Raffel, C., Bach, S. H., Sutawika, L., Alyafeai, Z., Chaffin, A., Stiegler, A., Scao, T. L., Raja, A., et al. (2021). Multitask prompted training enables zero-shot task generalization. arXiv preprint arXiv:2110.08207.

[66].Schick, T., Udupa, S., and Schütze, H. (2021). Self-diagnosis and self-debiasing: A proposal for reducing corpus-based bias in nlp. arXiv preprint arXiv:2103.00453.

[67].Schulman, J., Moritz, P., Levine, S., Jordan, M., and Abbeel, P. (2016). High-dimensional continuous control using generalized advantage estimation. In Proceedings of the International Conference on Learning Representations (ICLR).

[68].Schulman, J., Wolski, F., Dhariwal, P., Radford, A., and Klimov, O. (2017). Proximal policy optimization algorithms. arXiv preprint arXiv:1707.06347.

[69].Sheng, E., Chang, K.-W., Natarajan, P., and Peng, N. (2019). The woman worked as a babysitter: On biases in language generation. arXiv preprint arXiv:1909.01326.

[70].Silver, D., Hubert, T., Schrittwieser, J., Antonoglou, I., Lai, M., Guez, A., Lanctot, M., Sifre, L., Kumaran, D., Graepel, T., et al. (2017). Mastering chess and shogi by self-play with a general reinforcement learning algorithm. arXiv preprint arXiv:1712.01815.

[71].Soares, N., Fallenstein, B., Armstrong, S., and Yudkowsky, E. (2015). Corrigibility. In Workshops at the Twenty-Ninth AAAI Conference on Artificial Intelligence.

[72].Socher, R., Perelygin, A., Wu, J., Chuang, J., Manning, C. D., Ng, A. Y., and Potts, C. (2013). Recursive deep models for semantic compositionality over a sentiment treebank. In Proceedings of the 2013 conference on empirical methods in natural language processing, pages 1631–1642.

[73].Solaiman, I., Brundage, M., Clark, J., Askell, A., Herbert-Voss, A., Wu, J., Radford, A., Krueger, G., Kim, J. W., Kreps, S., et al. (2019). Release strategies and the social impacts of language models. arXiv preprint arXiv:1908.09203.

[74].Solaiman, I. and Dennison, C. (2021). Process for adapting language models to society (palms) with values-targeted datasets. arXiv preprint arXiv:2106.10328.

[75].Stiennon, N., Ouyang, L., Wu, J., Ziegler, D. M., Lowe, R., Voss, C., Radford, A., Amodei, D., and Christiano, P. (2020). Learning to summarize from human feedback. arXiv preprint arXiv:2009.01325.

[76].Tamkin, A., Brundage, M., Clark, J., and Ganguli, D. (2021). Understanding the capabilities, limitations, and societal impact of large language models. arXiv preprint arXiv:2102.02503.

[77].Thoppilan, R., De Freitas, D., Hall, J., Shazeer, N., Kulshreshtha, A., Cheng, H.-T., Jin, A., Bos, T., Baker, L., Du, Y., et al. (2022). Lamda: Language models for dialog applications. arXiv preprint arXiv:2201.08239.

[78].Vig, J., Gehrmann, S., Belinkov, Y., Qian, S., Nevo, D., Singer, Y., and Shieber, S. M. (2020). Investigating gender bias in language models using causal mediation analysis. In NeurIPS.

[79].Völske, M., Potthast, M., Syed, S., and Stein, B. (2017). Tl; dr: Mining reddit to learn automatic summarization. In Proceedings of the Workshop on New Frontiers in Summarization, pages 59–63.

[80].Wang, A., Pruksachatkun, Y., Nangia, N., Singh, A., Michael, J., Hill, F., Levy, O., and Bowman, S. R. (2019). Superglue: A stickier benchmark for general-purpose language understanding systems. arXiv preprint arXiv:1905.00537.

[81].Wei, J., Bosma, M., Zhao, V. Y., Guu, K., Yu, A. W., Lester, B., Du, N., Dai, A. M., and Le, Q. V. (2021). Finetuned language models are zero-shot learners. arXiv preprint arXiv:2109.01652.

[82].Weidinger, L., Mellor, J., Rauh, M., Griffin, C., Uesato, J., Huang, P.-S., Cheng, M., Glaese, M., Balle, B., Kasirzadeh, A., et al. (2021). Ethical and social risks of harm from language models. arXiv preprint arXiv:2112.04359.

[83].Welbl, J., Glaese, A., Uesato, J., Dathathri, S., Mellor, J., Hendricks, L. A., Anderson, K., Kohli, P., Coppin, B., and Huang, P.-S. (2021). Challenges in detoxifying language models. arXiv preprint arXiv:2109.07445.

[84].Wu, J., Ouyang, L., Ziegler, D. M., Stiennon, N., Lowe, R., Leike, J., and Christiano, P. (2021). Recursively summarizing books with human feedback. arXiv preprint arXiv:2109.10862.

[85].Xu, A., Pathak, E., Wallace, E., Gururangan, S., Sap, M., and Klein, D. (2021). Detoxifying language models risks marginalizing minority voices. arXiv preprint arXiv:2104.06390.

[86].Xu, J., Ju, D., Li, M., Boureau, Y.-L., Weston, J., and Dinan, E. (2020). Recipes for safety in open-domain chatbots. arXiv preprint arXiv:2010.07079.

[87].Yi, S., Goel, R., Khatri, C., Cervone, A., Chung, T., Hedayatnia, B., Venkatesh, A., Gabriel, R., and Hakkani-Tur, D. (2019). Towards coherent and engaging spoken dialog response generation using automatic conversation evaluators. arXiv preprint arXiv:1904.13015.

[88].Zellers, R., Holtzman, A., Bisk, Y., Farhadi, A., and Choi, Y. (2019). Hellaswag: Can a machine really finish your sentence? In Association for Computational Linguistics, pages 4791–4800.

[89].Zhao, M., Anderson, P., Jain, V., Wang, S., Ku, A., Baldridge, J., and Ie, E. (2021). On the evaluation of vision-and-language navigation instructions. arXiv preprint arXiv:2101.10504.

[90].Zhou, W. and Xu, K. (2020). Learning to compare for better training and evaluation of open domain natural language generation models. arXiv preprint arXiv:2002.05058.

[91].Ziegler, D. M., Stiennon, N., Wu, J., Brown, T. B., Radford, A., Amodei, D., Christiano, P., and Irving, G. (2019). Fine-tuning language models from human preferences. arXiv preprint arXiv:1909.08593.

报告信息

证券研究报告:《训练语言模型以遵循带有人类反馈的指令——德邦金工文献精译第八期》

对外发布时间:2023年3月16日

分析师:肖承志

资格编号:S0120521080003

邮箱:xiaocz@tebon.com.cn

报告发布机构:德邦证券股份有限公司

(已获中国证监会许可的证券投资咨询业务资格)

分析师简介

肖承志,同济大学应用数学本科、硕士,现任德邦证券研究所首席金融工程分析师。具有6年证券研究经历,曾就职于东北证券研究所担任首席金融工程分析师。致力于市场择时、资产配置、量化与基本面选股。撰写独家深度“扩散指标择时”系列报告;擅长各类择时与机器学习模型,对隐马尔可夫模型有深入研究;在因子选股领域撰写多篇因子改进报告,市场独家见解。

吴金超,清华大学工学硕士,南开大学本科,曾任职于东北证券、广发证券,2021年11月加入德邦证券。主要负责指数择时、行业轮动、基本面量化选股等工作。

林宸星,美国威斯康星大学计量经济学硕士,上海财经大学本科,主要负责大类资产配置、中低频策略开发、FOF策略开发、基金研究、基金经理调研和数据爬虫等工作,2021年9月加入德邦证券。

路景仪,上海财经大学金融专业硕士,吉林大学本科,主要负责基金研究,基金经理调研等工作,2022年6月加入德邦证券。

王治舜,香港中文大学金融科技硕士,电子科技大学金融+计算机双学士,主要负责量化金融、因子选股等工作,2023年1月加入德邦证券。

感谢实习生王宣淇和管俊凯对本文做出的贡献。

MORE

相关阅读

01 策略报告

【德邦金工|年度策略】全球成长股或将迎来绝地反击——德邦金工2023年度策略报告

【德邦金工|中期策略】云销雨霁,尚待黎明20210824

02 每周行情前瞻

【德邦金工|周报】北向净买入机械、建筑,创业类指数标的ETF净流入居前——德邦金工择时周报 20230312

【德邦金工|周报】全球股市普涨,消费、通信行业景气度提升——德邦金工择时周报 20230305

【德邦金工|周报】A 股上涨领先全球,家电、非银行业景气度提升 ——德邦金工择时周报 20230226

【德邦金工|周报】创业类ETF净流入继续居前,融资买入计算机、国防军工 ——德邦金工择时周报20230219

【德邦金工|周报】北向资金买入食饮、非银,创业类ETF净流入居前——德邦金工择时周报20230212

【德邦金工|周报】节后首周两市成交明显放大,证券ETF净流入居前——德邦金工择时周报20230205

【德邦金工|周报】A股继续收红,军工类ETF净流入整体居前——德邦金工择时周报20230115

【德邦金工|周报】市场情绪修复,TMT行业ETF净流入居前——德邦金工择时周报20230108

【德邦金工|周报】A股整体上涨收官,房地产融资净买入继续居前——德邦金工择时周报20230101

【德邦金工|周报】融资净买入房地产,红利ETF净流入居前——德邦金工择时周报20221225

【德邦金工|周报】北向买入医药、银行,创业类指数标的ETF净流入持续居前——德邦金工择时周报20221218

【德邦金工|周报】A股主要指数集体上涨,创业类指数标的ETF净流入居前——德邦金工择时周报20221211

【德邦金工|周报】A股渐入佳境整体上涨,沪深300指数标的ETF净流入居前——德邦金工择时周报20221204

03 大类资产配置观点

04 机器学习专题

【德邦金工|选股专题】中证1000成分股有效因子测试——中证1000指数增强系列研究之一

【德邦金工|选股专题】基于模型池的机器学习选股——德邦金工机器学习专题之五

【德邦金工|选股专题】动态因子筛选——德邦金工机器学习专题之四

【德邦金工|机器学习】基于财务与风格因子的机器学习选股——德邦金工机器学习专题之三

05 金融产品时评

06 金融产品专题

【德邦金工|金融产品专题】后疫情时代,物流行业有望复苏,推荐关注物流ETF ——德邦金融产品系列研究之十八

【德邦金工|金融产品专题】势不可挡,坚定不移走科技强国之路,推荐关注华宝中证科技龙头ETF——德邦金融产品系列研究之十七

【德邦金工|金融产品专题】“抓住alpha,等待beta”,华宝夏林锋主动出击“三年一倍”目标——德邦权益基金经理系列研究之一

【德邦金工|金融产品专题】乘大数据战略机遇,握新时代“价值资产”,推荐关注大数据ETF——德邦金融产品系列研究之十六

【德邦金工|金融产品专题】招商中证1000指数增强——细分赛道下的“隐形冠军”——德邦金融产品系列研究之十五

【德邦金工|金融产品专题】长风破浪,王者归来,纳斯达克100ETF再启航——德邦金融产品系列研究之十四

【德邦金工|金融产品专题】风劲帆满海天远,雄狮迈步新征程,推荐关注军工龙头ETF——德邦金融产品系列研究之十三

【德邦金工|金融产品专题】“小”“智”“造”与大机遇,推荐关注中证1000ETF——德邦金工金融产品系列研究之十二

【德邦金工|金融产品专题】“专精特新”政策赋能,小市值投资瞬时顺势,推荐关注国证2000ETF——德邦金工金融产品研究之十一

【德邦金工|金融产品专题】面向未来30年,布局“碳中和”大赛道,推荐关注碳中和龙头ETF——德邦金工金融产品研究之十

【德邦金工|金融产品专题】互联网东风已至,龙头反弹可期,推荐关注互联网龙头ETF——德邦金融产品系列研究之九

【德邦金工|金融产品专题】需求旺盛供给紧俏,稀土ETF重拾上升趋势——德邦金融产品系列研究之八

【德邦金工|金融产品专题】周期拐点将至,地缘冲突催化行业景气上行,关注农业ETF——德邦金融产品系列研究之七

【德邦金工|金融产品专题】新能源车需求超预期,动力电池新产能涌现,关注锂电池ETF——德邦金融产品系列研究之六

【德邦金工|金融产品专题】稳增长预期下高股息低估值凸显投资价值,关注中证红利 ETF——德邦金融产品系列研究之五

【德邦金工|金融产品专题】文旅复苏之路,价值实现的选择,关注旅游ETF——德邦金融产品系列研究之四

【德邦金工|金融产品专题】市场波动渐增,银行防御价值凸显——德邦金融产品系列研究之三

07 选股月报

08 文献精译

【德邦金工| Fama因子模型专题】Fama三因子模型问世三十周年系列之二:A股市场实证——德邦金工Fama因子模型专题二

【德邦金工|文献精译】Fama-French三因子模型问世三十周年系列之一:重温经典——德邦金工Fama因子模型专题一

【德邦金工|文献精译】股价是否充分反映了业绩中应计和现金流部分所蕴含的未来盈利信息?——德邦金工文献精译系列之七

【德邦金工|文献精译】资产配置:管理风格和绩效衡量——德邦金工文献精译系列之六

【德邦金工|文献精译】规模很重要,如果控制了绩差股——德邦金工文献精译系列之五

【德邦金工|文献精译】中国股市的规模和价值因子模型——德邦金工文献精译系列之四

【德邦金工|文献精译】机器学习驱动下的金融对不确定性的吸收与加剧——德邦文献精译系列之三

09 小市值专题

10 行业轮动专题

11 分析师专题

【德邦金工|选股专题】基于事件分析框架下的分析师文本情绪挖掘——分析师专题之一

12 基金策略专题

【德邦金工|金融产品专题】基于主动基金持仓的扩散指标行业轮动及改进—基金投资策略系列研究之一

本篇文章来源于微信公众号: Zeta金工研究